Rekonstruktion von Wörtern Hirnströme sind "hörbar"

01.02.2012, 08:32 Uhr

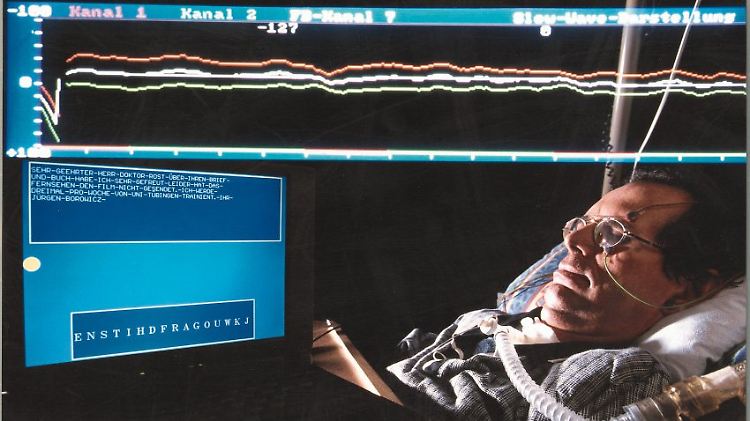

Mit dem Foto "Kommunikation via Hirnströme", das einen Mann zeigt, der an einen Apparat zur Messung der Hirnströme angeschlossen ist, gewann der Hamburger Fotograf Marc Steinmetz im Jahr 2008 den zweiten Preis (Einzelfoto) beim Fotowettbewerb "Wissenschaft visuell" der Zeitschrift "bild der wissenschaft".

(Foto: picture-alliance/ dpa)

Zum Gedankenlesen reicht es noch nicht - aber ein kleiner Schritt in die Richtung ist es unter Umständen: US-Forscher rekonstruieren aus den Hirnströmen einiger Probanden in geringen Umfang, was diese Menschen gehört haben. Langfristig soll diese Technik einmal beispielsweise Schlaganfall-Patienten helfen.

US-Forscher haben Hirnströme von Menschen "hörbar" gemacht. Sie analysierten die Aktivität des Gehirns in einer bestimmten Region, während die Studienteilnehmer Stimmen lauschten. Die Daten wurden in ein Computermodell eingespeist. Fütterten die Wissenschaftler den Rechner anschließend mit neuen Hirnstrom-Daten, so konnten sie ansatzweise Wörter rekonstruieren, die die Probanden gehört hatten.

Das Team aus Hirnchirurgen und Neurowissenschaftlern um Brian Pasley von der Universität von Kalifornien in Berkeley berichtet über die Tests mit 15 Patienten im Online-Journal "PLoS Biology". Die Forscher hoffen, dass sie in Zukunft einmal gedachte Wörter oder Sätze analysieren können, und wollen so Patienten helfen, die beispielsweise nach einem Schlaganfall nicht mehr sprechen können.

Für die Studie wurden Patienten untersucht, die sich wegen schwerer Epilepsie oder eines Hirntumors operieren lassen mussten. Vor solchen Operationen wird den Patienten ein Netz von Elektroden direkt auf das Gehirn gesetzt, um herauszufinden, von wo die Krampfanfälle ausgehen, und wo operiert werden muss. Die Elektroden seien den Patienten einige Tage bis etwa eine Woche vor der Operation eingesetzt worden, sagte Studienautor Pasley der Nachrichtenagentur dpa.

Treffsicherheit von 20 bis 30 Prozent

Zu den englischen Begriffen gehörten Wörter wie "Jazz" oder "Deep", sowie erfundene Pseudowörter. Teils wurden die Wörter von einer Frau auf Band gesprochen, und den Patienten vorgespielt; zehn Patienten hörten isolierte Wörter, fünf Patienten ganze Sätze von Männern oder Frauen. Die Hirnströme wurden über einer Region der Großhirnrinde gemessen, die beim Hören eine wichtige Rolle spielt.

Mit einer Treffsicherheit von durchschnittlich 20 bis 30 Prozent konnten Pasley und Kollegen die gehörten Worte rekonstruieren, etwa auch die Anzahl der Silben. Es konnten Klangbilder erzeugt werden, die den Originalworten so ähnelten, dass die Forscher das Wort häufiger richtig erkennen konnten, als es der Zufall erlaubt hätte. Je mehr Elektroden auf dem Gehirn auflagen, desto besser war das Ergebnis.

Für Jonas Obleser vom Max-Planck-Institut für Kognitions- und Neurowissenschaften (Leipzig) ist die PLoS Biology-Studie "einzigartig". "Das Team will den Code knacken, wie gesprochene Sprache funktioniert. Es fehlt aber ein großer, wahrscheinlich entscheidender Schritt: Passiert dasselbe im Gehirn, wenn ich das Wort "Jazz" höre oder "Jazz" denke?", sagte Obleser. Diese Einschränkung machen auch Pasley und Kollegen selbst.

Umfassendes Forschungsgebiet

Die Frage bleibt offen, ob die Hirnsignale bei der Wahrnehmung und in der Vorstellungskraft identisch sind. Es gibt jedoch laut Pasley Hinweise darauf. Wenn die Beziehung gut genug verstanden würde, so könne man entweder Klänge aus den Hirnsignalen herstellen, wenn ein Mensch denkt, oder die Worte von einem Gerät aufschreiben lassen.

Nach Meinung des Wissenschaftlers Christoph Schreiner ist die Studie wichtig, weil akustische Eigenschaften von Sprachsignalen bei Menschen bis in die ersten Stationen in der Großhirnrinde verfolgt werden können. Der deutsche Forscher, der seit mehr als 30 Jahren in den USA arbeitet, betont jedoch ebenfalls, dass akustische Signale noch nicht das Sprachverständnis ausmachen: "Wenn drei verschiedene Leute "Apfel" sagen, dann erhält das Gehirn nicht die gleichen akustischen Signale, die Frequenzen der Stimmen sind beispielsweise anders, aber das Gehirn denkt sich - aha, das ist nicht ganz identisch, aber das gleiche ist gemeint", sagte Schreiner von der Universität von Kalifornien in San Francisco (UCSF) der dpa.

"Das heißt, irgendwo im Gehirn erhalten die akustischen Signale eine Bedeutung, und wie das genau funktioniert und wo diese Transformation stattfindet, das wissen wir noch nicht." Von der UCSF stammt auch der Studienautor Edward Chang. Schreiner erforscht dort die Weiterleitung von akustischen Signalen bei Tieren. Von Gedankenlesen im Zusammenhang mit der nun veröffentlichten Studie möchte er nicht sprechen. "Gedanken sind sehr viel komplexer, und wir denken auch nicht immer in Worten."

Quelle: ntv.de, dpa