Haftstrafen für KI-Maschinen?Roboter-Recht bringt Juristen ins Grübeln

Der revolutionäre Fortschritt der Künstlichen Intelligenz begeistert nicht nur Wissenschaftler in aller Welt. Auch Juristen müssen sich mittlerweile ernsthaft mit Fragen des Haftungsrechts befassen. Sind Computer und Maschinen für ihr Handeln verantwortlich?

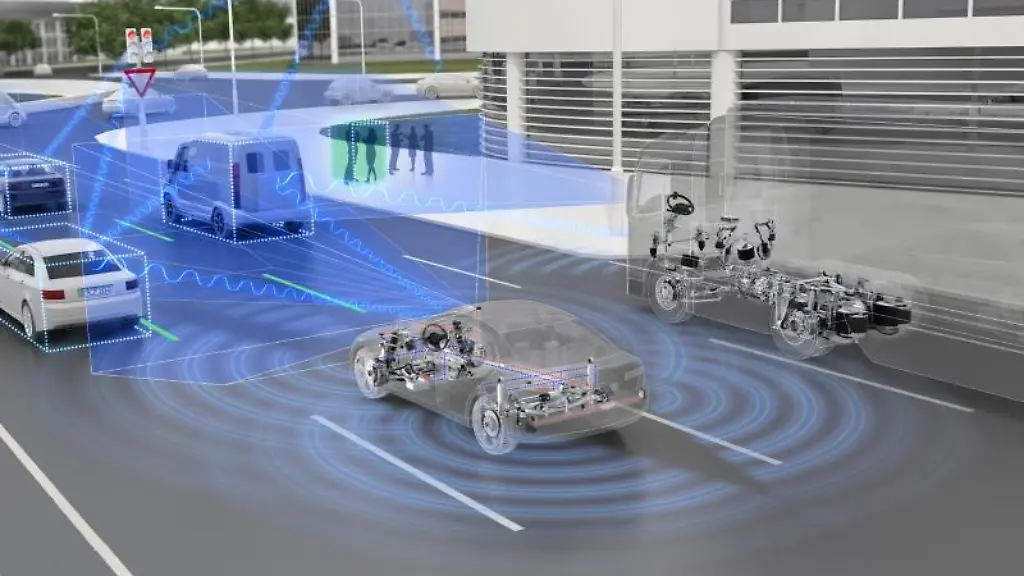

Es ist ein Alptraum für jeden Autofahrer: Eine Fußgängerin tritt unvermittelt auf die Straße - es bleiben nur Sekundenbruchteile, um ein tödliches Unglück abzuwenden. Bei Unfällen haftet nach deutschem Recht in aller Regel bislang der Fahrer beziehungsweise der Halter des Fahrzeugs. Doch was ist, wenn der Fahrer eine Maschine ist, der Mensch hinter dem Steuer nur Passagier? Ein derartiger Unfall ereignete sich im März in den USA mit einem Roboterauto des Fahrdiensts Uber. Eine 49-Jährige kam ums Leben, die Schuldfrage ist bislang nicht geklärt.

Der rasante Fortschritt der künstlichen Intelligenz (KI) beschäftigt längst auch die Juristen in Europa. Im Haftungsrecht werden inzwischen Fragen diskutiert, die vor zwanzig Jahren noch jeder für Science Fiction erklärt hätte. Das hat auch Bedeutung für die Versicherungen, die bei Unfällen zahlen. "Maschinen mit Lern-Algorithmen werden in immer größerem Umfang Fahraufgaben im Auto übernehmen und schrittweise das menschliche Verschulden verdrängen", sagt Joachim Müller, Chef der Sachversicherung bei der Allianz Deutschland. "Für die Folgen ihres Handelns können Maschinen derzeit rechtlich aber nicht verantwortlich gemacht werden."

Bislang wenden sich Unfallermittler und Versicherer bei der Klärung der Schuldfrage zunächst an den Fahrer beziehungsweise den jeweiligen Fahrzeughalter. Die Autohersteller können nur dann rechtlich zur Verantwortung gezogen werden, wenn ein Produktionsfehler einen Unfall verursacht. Doch künstliche Intelligenz am Steuer macht Unfälle denkbar, bei denen kein technischer Defekt vorliegt, sondern der Computer einfach eine falsche Entscheidung getroffen hat.

Selbstlernende Software kann auf Grundlage zuvor eingegebener Daten quasi selbsttätig Muster und Situationen erkennen und darauf reagieren. "Es erscheint mir schwierig, Programmen ein Verschulden anzulasten - egal ob sie ausschließlich einem vorgegebenen Algorithmus folgen oder sich selbstständig weiterentwickeln", sagt Allianz-Vorstandsmitglied Müller dazu.

Bei der Debatte geht es keineswegs nur um Roboterautos. Schon wird diskutiert, ob KI-Maschinen generell nicht eine eigene Rechtspersönlichkeit zugesprochen werden sollte. Dann könnte die künstliche Intelligenz quasi selbst haften. Das Europäische Parlament empfahl der EU-Kommission Anfang 2017, darüber nachzudenken. Doch der Einführung einer Rechtspersönlichkeit für Roboter stehen nicht zuletzt auch praktische Gründe entgegen: Eine Maschine habe kein Konto, heißt es. Letztlich müsste also immer ein dahinter stehender Mensch oder ein Unternehmen zur Rechenschaft gezogen werden.

"Keine Revolution vonnöten"

Und es würde sich eine noch weitergehende Frage stellen: Wenn eine Maschine zivilrechtlich verantwortlich sein kann, muss dann nicht auch das Strafrecht geändert werden? "Wird das selbstfahrende Auto in der Garage inhaftiert? Verschrottet?", fragt etwa Allianz-Manager Müller nur halb im Scherz. Kriminelle Maschinen im Knast bleiben vorerst Science Fiction. Doch sollten für computerverursachte Unfälle nicht die Autohersteller haften?

"Das kann sich der Gesetzgeber überlegen", sagt der Rechtswissenschaftler Stephan Lorenz, Lehrstuhlinhaber für Bürgerliches Recht und Internationales Privatrecht an der Ludwig-Maximilians-Universität in München. "Ich persönlich halte das nicht für sinnvoll, denn auch bisher ist es schon so, dass für Produktfehler der Hersteller haftet."

Lorenz hält die derzeitigen Regelungen für ausreichend: "Es ist aus juristischer Sicht keine Revolution vonnöten." Nach geltender Rechtslage hafte im Autoverkehr der Halter für Schäden, die mit seinem Fahrzeug verursacht werden. "Es gilt hier wegen der potenziellen Gefahr das Prinzip der Gefährdungshaftung." Dieses besagt, dass für den Betrieb bestimmter potenziell gefährlicher Maschinen und Anlagen - dazu zählen etwa Autos, Züge, Flugzeuge und Atomkraftwerke - der Betreiber haftet. "Diese Haftung reicht aus, auch wenn das Auto selbst fährt", sagt Rechtswissenschaftler Lorenz. Auch nach Einschätzung des Bundesjustizministeriums besteht derzeit kein Handlungsbedarf.

Regelungen zum automatisierten Fahren sind erst 2017 in das Straßenverkehrsgesetz aufgenommen worden. "Bisher sehen wir keinen Grund, dass wir an der bewährten Reihenfolge der Haftung etwas ändern sollten", sagt ein Sprecher. Doch da die Technik rapide fortschreitet, ist das letzte Wort in dieser Debatte längst noch nicht gesprochen. Auch in den USA ist es bisher so, dass die Hersteller nur für Produktionsmängel haften. Die Denkfabrik "US Chamber Institute für Legal Reform" brachte jedoch erst kürzlich das Argument vor, dass dieses Prinzip nicht mehr angemessen sei - weil KI-Software nach dem Verkauf dazulerne und sich verändere. Ein potenzieller Fehler könnte somit erst lange nach Abschluss der Produktion entstehen.

Der Versicherungskonzern Allianz plädiert zumindest dafür, über ein Gesetz zur Verwendung von künstlicher Intelligenz nachzudenken. "Dieses Gesetz sollte einen Gefährdungshaftungstatbestand enthalten", sagt Sachversicherungschef Müller. Dies würde bedeuten, dass KI dann rechtlich ähnlich zu betrachten wäre wie Auto und Atomkraftwerk: als potenziell gefährlich.